Les Agents IA, ou comment l’IA apprend à “faire” des choses

Il y a quelques semaines, j’étais à la conférence Dell Technologies. Un des intervenants a dit une phrase qui m’a marqué :

“La technologie avance plus vite que notre capacité à l’adopter.”

Et c’est tellement vrai.

À peine a-t-on commencé à comprendre un nouvel outil, qu’un autre, encore plus sophistiqué, débarque. Et on se retrouve à courir derrière le train de l’innovation, sans vraiment savoir où il va.

Prenez ChatGPT par exemple.

Cela fait quoi… trois ans à peine que ces outils sont sortis au grand public ? Et pourtant, beaucoup de gens n’ont pas encore eu le temps — ou le courage — de les apprivoiser. Qu’on parle déjà de “nouvelle génération d’IA agentique”, d’“agents autonomes”, de “multi-agent systems”…

Avouons-le : c’est déroutant.

Moi aussi, j’étais perdu au début.

Il faut dire qu’il règne une certaine confusion autour du terme “agent” : on l’utilisait bien avant l’ère du machine learning, et on continue de l’utiliser aujourd’hui dans des contextes très différents. Même les chercheurs et universitaires n’arrivent pas à s’accorder sur une définition unique. La plupart disent qu’un agent doit avoir un objectif et agir de manière autonome… mais, dans ce cas, beaucoup de logiciels traditionnels pourraient déjà être qualifiés d’agents.

Ma première rencontre avec un “Agent”

Ma première expérience avec un agent, c’était avec Claude Agent, il y a plusieurs mois.

Je m’en souviens bien : il fallait installer un environnement virtuel avec Docker pour le faire tourner.

Curieux, je lui ai donné une tâche simple :

“Télécharge des images de chats.”

Et là, j’ai regardé, fasciné, l’agent ouvrir son propre navigateur, taper des requêtes, cliquer sur des liens, et enfin télécharger une image.

C’était incroyable à observer… mais un peu frustrant aussi.

Cinq minutes pour récupérer une seule image de chat.

Cinq minutes !

Moi, je mets à peine cinq secondes.

Techniquement impressionnant, oui. Pratiquement utile ? Pas vraiment.

Nous avions d’ailleurs enregistré un webinaire sur le sujet, disponible en replay sur notre site web.

Et puis le mot “Agent” est revenu…

Quelques mois plus tard, le terme “agent” a refait surface.

Je voulais comprendre.

Je suis tombé sur des tutos parlant de Make ou n8n. Des outils d’automatisation que j’utilisais déjà, mais je ne voyais pas le rapport avec “Claude Agent”.

J’ai laissé tomber.

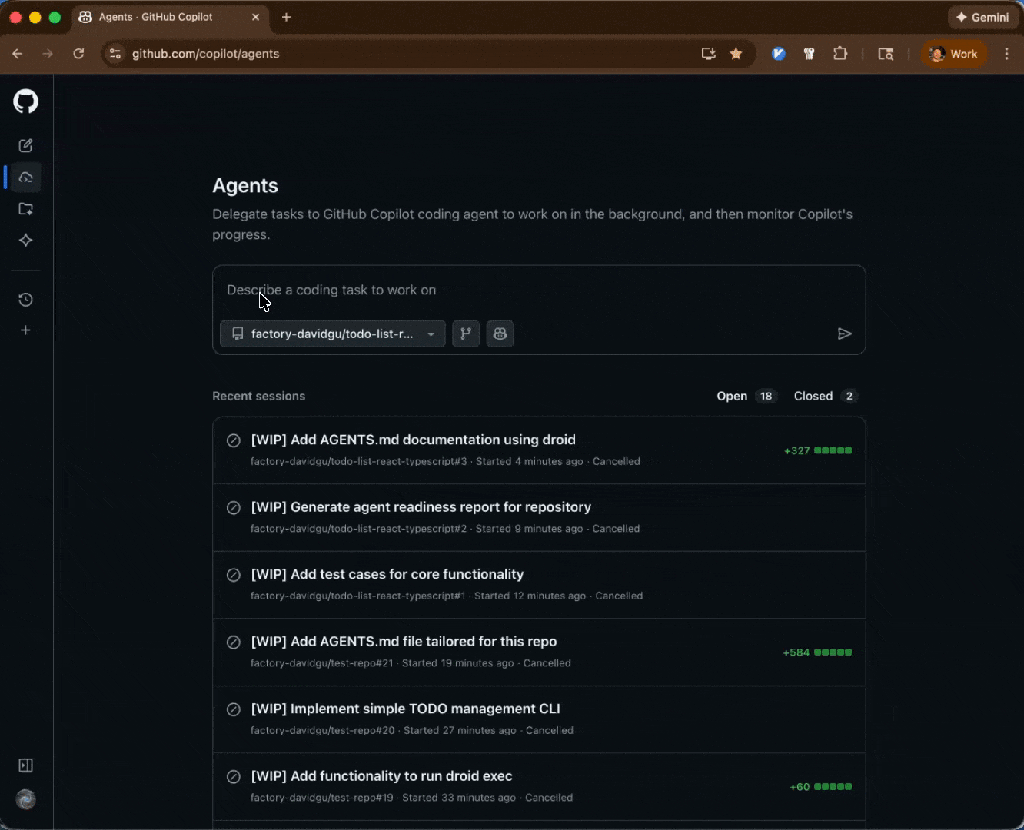

Et puis un jour, pendant une formation à GitHub Copilot pour développeurs, j’ai découvert son nouveau mode “agent”.

Là, surprise : Copilot ne se contentait plus de suggérer du code. Il installait des paquets, créait des dossiers, exécutait des commandes.

Il faisait des choses.

Et je me suis dit : “Tiens, ça, c’est un vrai agent. Il installe des trucs et met à jour mon projet, c’est plutôt cool !”

Et ChatGPT s’y est mis aussi

Quelques mois plus tard, ChatGPT a lui aussi proposé un mode Agent.

Un peu comme Claude : un navigateur virtuel qui exécute des actions dans un environnement isolé.

Mais cette fois, je commençais à comprendre.

Alors la grande question :

Quel rapport entre l’agent de ChatGPT, celui de GitHub Copilot, et ceux qu’on crée sur Make ou n8n ?

La réponse est finalement assez simple :

Tous ces agents ont un point commun.

Ils ne se contentent plus de générer du texte.

Ils exécutent des actions.

L’agent, c’est une automatisation… qui réfléchit

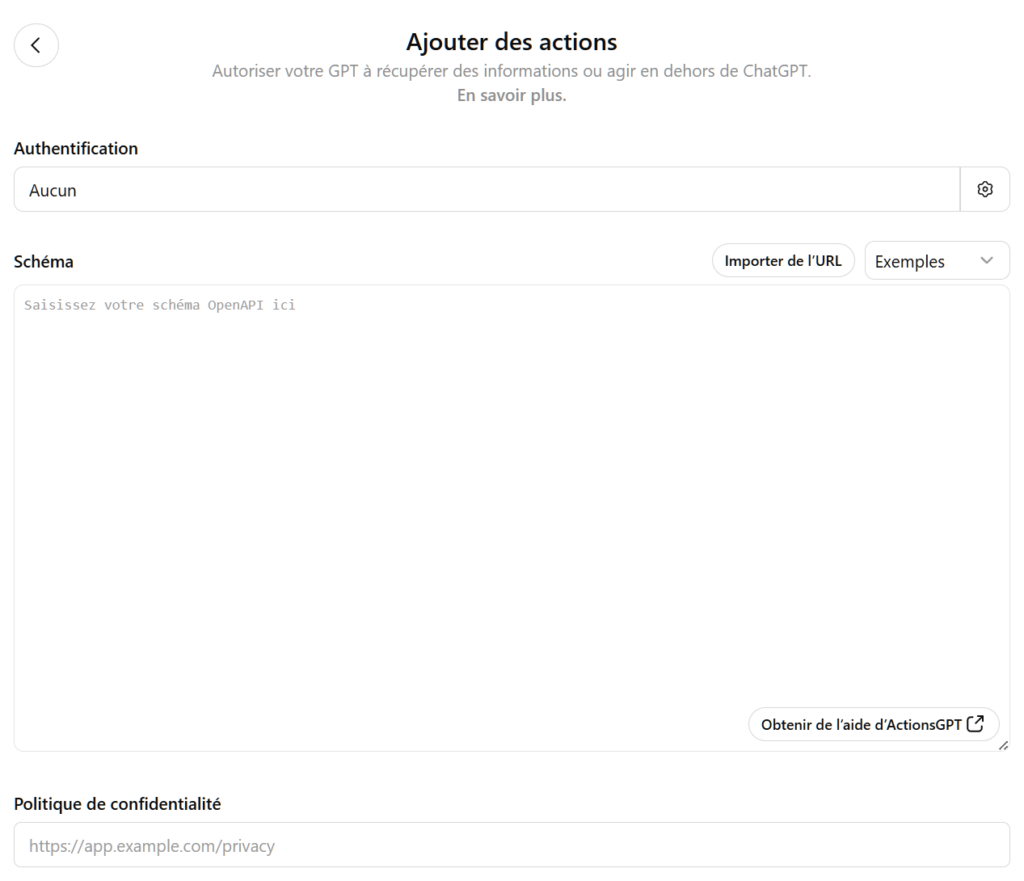

Si vous utilisez ChatGPT Plus, vous connaissez peut-être le concept “d’action” : la possibilité de connecter ChatGPT à d’autres applications (mails, calendrier, etc.) pour qu’il fasse quelque chose à votre place.

Mais ce principe, on le retrouve déjà depuis longtemps dans des outils comme Zapier, Make, ou n8n.

Prenons un exemple simple :

Dès que je reçois un mail de mon boss, j’enregistre son contenu dans une feuille de calcul “à faire”.

C’est une automatisation classique :

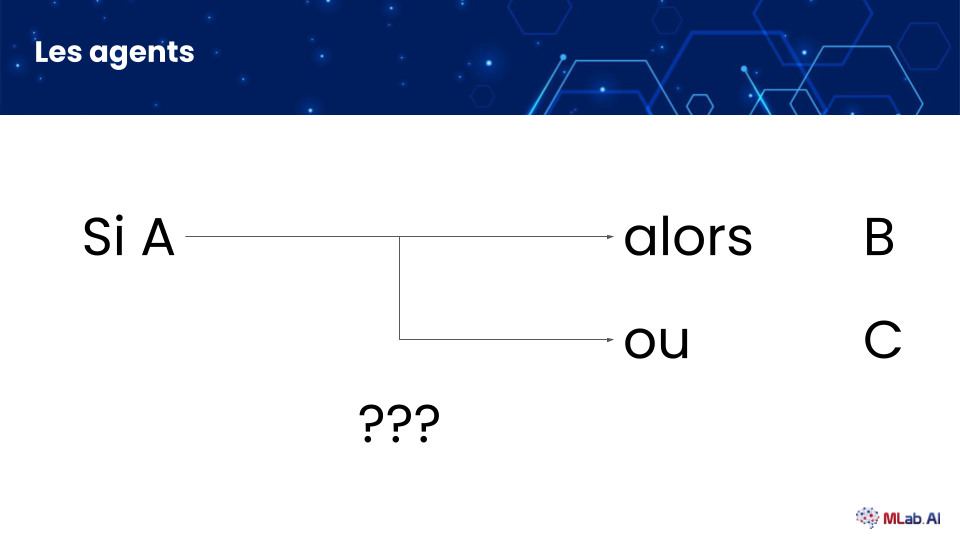

Si A se produit, alors B.

Maintenant, imaginons une version un peu plus intelligente :

Si le mail reçu contient quelque chose d’urgent, alors l’automatisation doit créer un événement dans mon calendrier.

Sinon, il faut la ranger dans le tableau. Il y a donc deux actions possibles A ou B

Mais du coup, la question se pose. Comment le script peut décider si faire A ou B ? Pas si simple que ça…

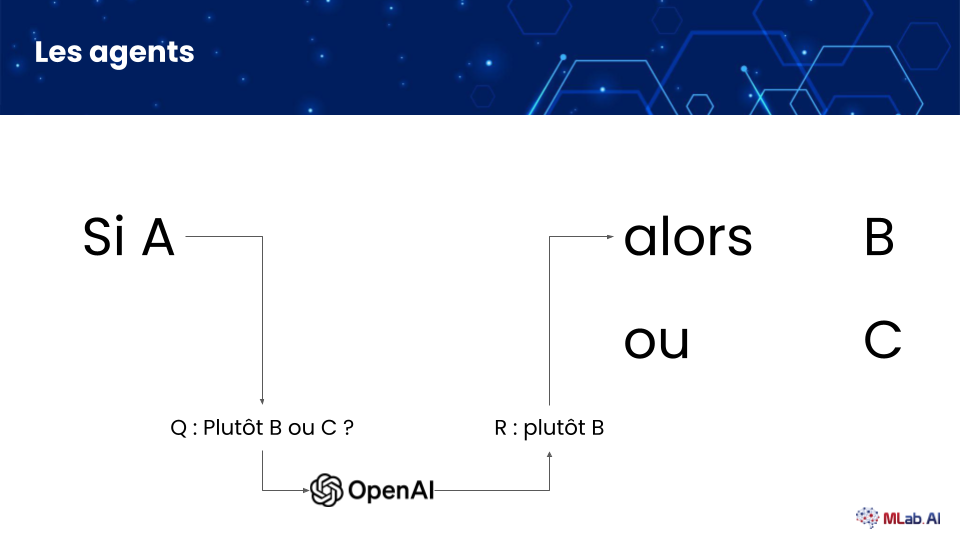

Mais on est en 2025 et nous avons la puissance des modèles de langage ! Il suffit de leur demander…

On envoie le contenu du mail à l’API d’OpenAI en lui demandant :

“Ce mail est-il urgent ? Si oui, réponds B, sinon, réponds C”

Et selon la réponse, on déclenche le bon scénario.

C’est ça, un agent.

Une automatisation qui délègue une partie de la décision à un modèle de langage. Le mariage parfait des systèmes déterministes avec un peu de probabilisme, pour prendre une décision.

Ces systèmes ne sont évidemment pas parfaits : parfois, la réponse ne sera pas la bonne, et au lieu de simplement dire “B” ou “C”, le modèle de langage répondra quelque chose d’inattendu comme “Ok, j’ai bien compris ce que tu veux faire” ou même “Je suis désolé, je ne peux pas t’aider avec ça”. Autrement dit, ces agents ne sont pas autonomes par magie : il faut les configurer, les tester et surtout les surveiller, ce qui, finalement, est tout à fait logique.

Et les “IA multi-agentiques” ?

Ce sont simplement des scénarios plus complèxes où plusieurs agents travaillent ensemble.

Certains décident, d’autres exécutent.

Une sorte d’entreprise virtuelle où chaque agent a son rôle, et les managers… ce sont des modèles de langage.

Sur le papier, c’est séduisant : une armée d’agents virtuels qui travaillent à notre place.

Dans la réalité, c’est plus nuancé.

On automatise ce qui fonctionne déjà et qu’on doit simplement répéter, mais dès que les conditions changent, ces automatisations deviennent obsolètes et doivent souvent être repensées depuis zéro. À ma connaissance, il n’existe pas encore de système d’agent capable d’évoluer seul et de s’adapter aux scénarios de la vie réelle — il faut toujours un humain pour concevoir, ajuster et faire évoluer ces systèmes.

Pourquoi les agents de ChatGPT et de GitHub Copilot sont différents

Tout simplement parce qu’ils n’ont pas accès à vos outils.

Ils fonctionnent dans un environnement fermé, avec des permissions limitées.

Alors qu’un agent que vous créez sur Make, n8n, ou même en code, a accès à vos vraies applications : vos mails, vos fichiers, vos bases de données.

C’est là qu’il devient vraiment utile… et qu’il faut aussi être prudent sur la confidentialité et la sécurité. C’est d’ailleurs un sujet qu’on aborde souvent en formation, et que je développerai dans un prochain article.

Le mode Agent de ChatGPT, lui, fonctionne d’une manière assez particulière : il prend comme input une demande en langage naturel de l’utilisateur, puis lance un navigateur virtuel qu’il contrôle directement — il peut bouger la souris, cliquer, faire défiler la page, remplir des formulaires, etc. C’est ainsi qu’OpenAI a tenté d’implémenter son concept d’agent. Ce qui serait réellement révolutionnaire, ce serait qu’OpenAI (ou l’un de ses concurrents) crée un agent capable de se connecter directement aux API d’acteurs comme Amazon, Google, Microsoft, Booking ou UberEats, sans passer par les interfaces web. Là, on aurait un système d’agent incroyablement puissant et surtout rapide… mais, à ma connaissance, ce type d’intégration n’existe pas encore.

Il existe d’ailleurs un protocole émergent appelé MCP (Model Context Protocol), conçu justement pour faciliter la connexion entre les modèles de langage et des outils externes — mais je reviendrai plus en détail sur ce sujet passionnant dans un prochain article.

Faire un agent, ce n’est pas la même chose que l’utiliser

Utiliser un agent, c’est magique.

Le créer, c’est formateur.

Parce que derrière la magie, il y a de la logique, des permissions, et de la conception d’automatisations.

Comprendre cette différence, c’est comprendre comment l’IA fonctionne vraiment.

Et c’est exactement ce que j’appelle “Parler IA” :

savoir décoder les concepts, expérimenter, relier la technique au concret.

D’ailleurs, on propose des formations autour des Agents et des automatisations dans notre catalgoue, n’hésitez pas à jetter un coup d’oeil !

La technologie avance vite, oui.

Mais apprendre à “parler IA”, c’est justement ce qui nous permet de rester dans le train,

et même parfois, d’aller dans la locomotive.

Pour aller plus loin :

- Consultez nos formations.

- Participez à nos webinar.

- Inscrivez-vous à notre newsletter.

Nous sommes un cabinet de conseil et formations en Intelligence Artificielle basé à Paris.

Discuter avec un expert en IA

Discuter avec un expert en IA est possible et complètement gratuit !

Réservez gratuitement et sans obligation d’achat un créneau de 30 minutes pour discuter avec un expert en IA !