Pourquoi ChatGPT, Claude & co ne sont pas (encore) vos meilleurs analystes de données

Je prépare en ce moment une formation que j’animerai la semaine prochaine, et comme souvent, je me retrouve à faire des tests, à explorer des cas concrets pour illustrer mes propos. Cette fois-ci, je voulais montrer les limites des modèles de langage comme ChatGPT ou Claude — et croyez-moi, elles sont fascinantes.

Il faut reconnaître que ces modèles sont incroyables dès qu’il s’agit de manipuler du texte.

Rédiger un article, le résumer, l’allonger, le reformuler dans un style plus professionnel, corriger l’orthographe, traduire un contenu ou le structurer… c’est leur terrain de jeu naturel.

Et ce n’est pas un hasard si l’un des premiers métiers à avoir tiré profit de ces modèles, ce sont les développeurs. Après tout, le code informatique, ce n’est que du texte.

Mais comme souvent, quand une technologie nous impressionne, on finit par la croire toute-puissante. On se dit : « Si ChatGPT comprend du texte, il doit comprendre tout, non ? » Eh bien, pas vraiment.

Quand l’IA se frotte aux données structurées

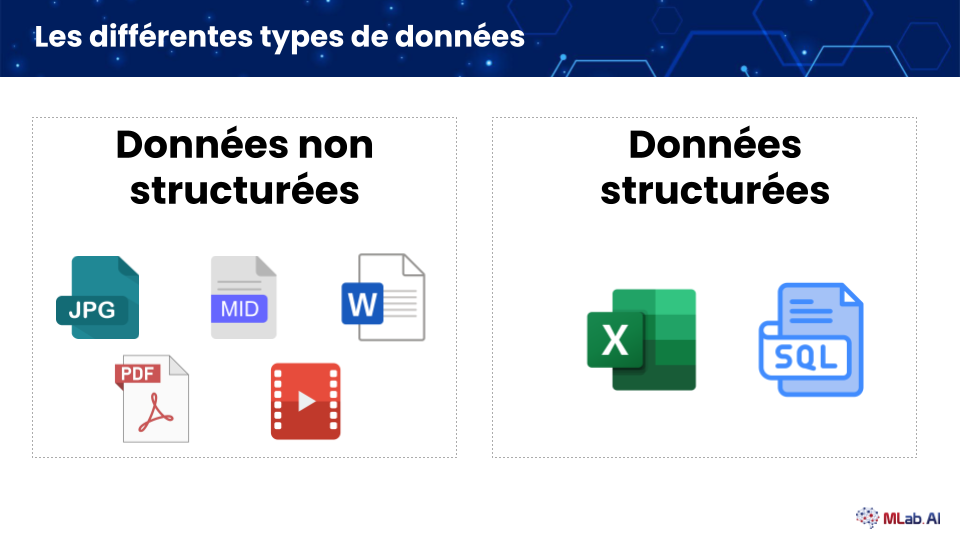

Quand on parle de types de données, il faut distinguer deux grandes familles : les données structurées et les données non structurées.

Les données structurées, ce sont celles qui tiennent dans un tableau : des lignes, des colonnes, des valeurs bien organisées. C’est ce qu’on retrouve dans nos fichiers Excel, nos bases de données clients, nos historiques de ventes ou nos relevés bancaires. Elles sont faciles à stocker, à trier, à analyser, car chaque information a une place précise.

À l’inverse, les données non structurées sont tout ce qui ne rentre pas dans des cases : les textes (comme celui que vous lisez en ce moment), les images, les sons et les vidéos. Ces données sont beaucoup plus riches, mais aussi plus complexes à exploiter, car leur contenu et leur signification ne sont pas directement “lisibles” par une machine sans un traitement spécifique. C’est justement sur ce type de données que les modèles d’IA générative brillent le plus aujourd’hui.

Les données structurées sont la colonne vertébrale de nos organisations modernes. Les stocker, les chercher, les analyser, les interpréter : c’est le quotidien de toutes les entreprises.

Alors forcément, beaucoup se sont posé la question :

« Si je donne mon tableau de ventes à ChatGPT, est-ce qu’il peut me dire combien je vais vendre l’an prochain ? Ou m’aider à mieux gérer mon business ? »

La réponse courte : non.

La vérité, c’est que les modèles de langage ne sont pas faits pour manipuler des données structurées. Ils savent générer du texte, pas analyser des chiffres.

Petit test : les chiffres et ChatGPT, une histoire compliquée

Je vous invite à faire un petit exercice.

Prenez un fichier Excel et posez à ChatGPT une question simple dessus.

Neuf fois sur dix, il va se tromper, inventer des chiffres ou produire une réponse approximative.

Et ce n’est pas de votre faute.

Ce n’est pas parce que vous avez « mal prompté ».

Ce n’est pas une question de technique, ni de formule magique.

Demandez-lui simplement :

« 453244 × 24342 = ? »

Neuf fois sur dix, il vous sortira un résultat… faux. Totalement inventé.

Et si vous avez déjà eu à “corriger” ChatGPT, vous savez à quel point c’est frustrant.

Mais ça, c’est un autre sujet (et probablement le thème de mon prochain article).

Pour les données structurées, revenons aux bases

Si vous voulez exploiter des données structurées, inutile de forcer un modèle de langage à le faire.

Les bons vieux outils que nous utilisons depuis des décennies le font mieux — et surtout, de manière fiable.

- Sur Excel :

=AVERAGE()pour la moyenne,=SUM()pour les totaux, et des dizaines d’autres fonctions éprouvées. - Si vous avez trop de données pour Excel, un petit script Python suffit. Une ligne comme :

mean(values)et vous aurez la réponse exacte… 100 fois sur 100 !!

Ce que les ingénieurs d’OpenAI ont compris

OpenAI (et les autres) sont bien conscients de cette limite.

C’est pour ça que ChatGPT a désormais une fonction “Analyse” : lorsqu’on lui pose une question sur des données, il écrit du code Python en coulisse, l’exécute, puis vous donne le résultat.

Mais attention : ce n’est pas systématique.

Parfois ça marche très bien… parfois, il faut croiser les doigts.

En conclusion : “Parler IA”, c’est aussi connaître ses limites

Les modèles de langage sont des outils extraordinaires, mais ils ne savent pas tout faire.

Comprendre leurs forces et leurs faiblesses fait partie de la culture que nous devons développer autour de l’intelligence artificielle.

Savoir quand faire confiance à un modèle de langage, et quand revenir à des outils plus simples — Excel, Python ou même une calculatrice —, c’est aussi ça, “parler IA”.

Pour aller plus loin :

- Consultez nos formations.

- Participez à nos webinar.

- Inscrivez-vous à notre newsletter.

Nous sommes un cabinet de conseil et formations en Intelligence Artificielle basé à Paris.

Discuter avec un expert en IA

Discuter avec un expert en IA est possible et complètement gratuit !

Réservez gratuitement et sans obligation d’achat un créneau de 30 minutes pour discuter avec un expert en IA !